算法 — 日常和人生十字路口陪伴你的“无形之手”

大数据、算法、人工智能、互联网、物联网......科技的发展为人类生活带来各种便利的同时,也在静悄悄地决定着人们的生活轨迹和命运。

假设,如果中国有一年取消高考,用算法根据历年成绩给每个应届毕业生打分,然后大学根据这个分数决定是否录取,录取到什么专业。

英国今年的中学毕业生对算法的这种威力有切身体验。

因为新冠疫情而取消了决定数万名中学毕业生命运的考试,用电脑算法( algorithm)给学生打分,让机器根据学校往年的考试结果,经过一番运算,得出今年毕业生的成绩。

决定命运的是高中毕业生的A-level 考试也决定了能否上大学,能上哪所大学。初中毕业,不再上学而开始求职谋生的,需要凭GCSE考试成绩去找工作。如果准备继续上学,日后申请大学时,这组成绩也是重要参考数据。

除了这种“十字路口”式的人生关键节点,算法在现代人生活中很多方面扮演着“无形之手”的角色,而我们未必知道。

BBC科技事务记者克雷顿(James Clayton)和克莱恩曼(Zoe Kleinman)梳理了几个算法左右命运的平台。

图像来源,Getty Images

社交媒体

从许多方面来看,社交媒体平台基本上就是庞然大物般的算法。

它们根据你所提供的,以及来自其他各种渠道的数据,确定你的兴趣、爱好、口味,然后为你推送更多它们认为你喜欢的内容。

这些数据包括你点的每一个“赞”,看的每一条讯息或视频,点击的每一个链接,都被记录存档。大部分应用软件还会从你的上网习惯和特点,以及地理位置等信息提取更多数据,关于你的数据。这些数据用来判断你喜欢什么,哪些内容吸引你的眼球,能让你在网上流连。

这个算法对你了解越多,对你生活的影响力就越大。 除了推送更多合你口味的内容,它自然还会用这个知识向你推销产品。

社交媒体公司收集储存的数据也被用来订制个人化的广告,定向投放,而且精准度高得令人咂舌。

当然,这类算法也会犯很严重的错误,惹大祸。比如它发现极端的、刺激的、重口味的、充满仇恨和煽动性的内容,在社交媒体上很吃香,比平淡普通的内容更赚眼球、点击和转发更多。所以有些人发现自己收到各种极端主义的、暴力的、仇恨的推送内容。

脸书针对民权问题做过一次内部审计,审计报告中明确提到,公司必须尽一切所能阻止它的算法把用户“驱赶到极端主义自我强化的回音室里去”。

算法还有一个盲点,那就是对种族歧视和仇恨类产品不加分辨地推送,导致投诉甚至吃官司。

图像来源,Getty Images

保险

保险公司需要评估风险,要做精算,无论是房产险、汽车险、寿险、医疗险,保费的多少依据这个评估结果来定。

许多人不知道的是,保险业很早就开始探索利用历年积累储存的数据来分析、预测未来;在电脑和算法尚未普及的时候就开始了。

有了算法,保险公司如虎添翼。

哈克尼斯(Timandra Harkness)是这方面专家,有一部关于大数据的专著(Big Data: Does Size Matter)。

有些显而易见但人们通常不太在意的事,背后就有算法的无形之手。

她举了个例子,比如家庭住址的邮编就决定了你的保费高低,而你在这些问题上毫无发言权,完全被动。

你的房产或车保险保费在搬家后涨了还是降了,跟你个人没有直接关系,而是跟这个地区的其他居民曾经,或者在多大程度上可能成为犯罪分子的受害者,或者遭遇水淹,或者出车祸,等等。

现在比较普遍的行车记录仪,汽车上的“黑匣子”,可以用来记录司机的驾车习惯,如果记录显示车主基本上是安全驾驶,即使其他指标都属于高风险群体,他/她的汽车险保费也可能降低。

这是利用算法制定个人化保险产品的一个例子。

保险行业的 实质是风险分摊,人人交保费,需要的人从钱库里取。个人化的保险产品能否普及,或许还需要算法来帮忙,确定这类新业务对保险公司有何利弊。

图像来源,Getty Images

医疗

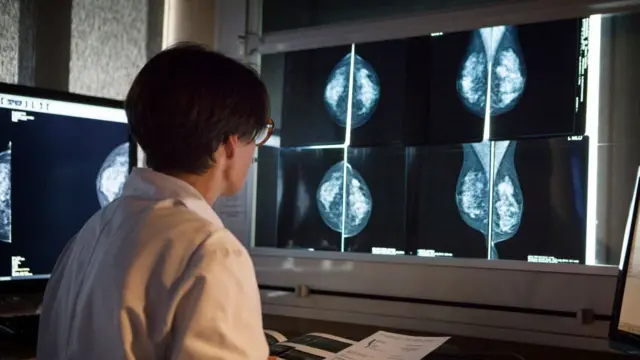

人工智能(AI)在疾病诊断方面的应用日益普及,有些地方AI甚至可以提出治疗方案和疗法建议。

2020年1月一项研究结果显示,通过X光片子诊断乳癌,算法的表现超过医生。

其他例子也有,比如可以预测子宫癌患者生存率的工具,这个工具还能帮助确定治疗方案。

伦敦大学学院(UCL)研发的人工智能可以分辨出哪些病人最容易忘记就诊预约,因此需要提醒服务。

海量数据是训练人工智能的必要前提。这就涉及到许多棘手的问题,包括病人隐私和个人数据保护。

2017年,英国信息委员会裁定,皇家自由医院NHS信托没有妥善保管病人数据,跟谷歌的人工智能子公司DeepMind分享了160万病人的数据。

图像来源,Getty Images

警务

大数据和机器学习对警察机构来说具有颠覆性的巨大潜力。

理论上,算法具备了科幻作品中描述的那种“预测警务”(predictive policing)的功能,可以利用历年刑事罪案的数据分析来确定警察资源的部署。

问题在于这种算法有先天缺陷,容易产生算法偏见,甚至形成算法种族歧视。

科技智库WebRoots Democracy专家乔杜里(Areeq Chowdhury)解释说,这就跟算法确定考试分数类似,实际上是根据别人过往的学业表现来给你打分,有什么道理?

他说,根据算法,一个特定社区很可能被不成比例地突出和强调。

国防和安全智库RUSI今年稍早发表了一份报告,阐述算法在警务实践中的应用。

报告提出一些需要关注的问题,包括没有全国统一的准则,也没有影响评估机制。

另一个需要深入研究的问题是算法如何放大、加剧种族主义倾向。

警务部门已经在使用的人脸识辨技术受到批评,矛头集中在用于机器学习的数据库是否会导致算法种族主义。

比如,用于人脸识别的摄像机识别白人更准确,是否因为它们背后的数据库里白人的面部数据更多?

这方面,数据是否足够多,足够多元化,就至关重要。

乔杜里说,最应该避免的是因为算法误判而错抓无辜。